摘要:

本文研究了利用深度学习模型ECAPA-TDNN对声发射波形数据进行模式识别的方法。声发射技术是一种重要的无损检测手段,传统分析方法多依赖于参数数据,而波形数据蕴含更多信息,可显著提升识别精度。ECAPA-TDNN模型通过引入SE-Res2Block模块、多层特征聚合与求和,以及注意力池化机制,能够有效捕捉复杂的时序特征,实现对断铅、摩擦、坠落和敲击等声发射事件的精确分类。实验采用GPU加速,结合数据预处理和数据增强技术,显著提高了训练效率与识别准确率。结果表明,该方法在测试集上的整体识别准确率达到93.7%,验证了其在声发射波形数据分析中的有效性与优越性。本文的研究为无损检测技术的发展提供了新的思路和工具,同时也为未来的模型优化和应用扩展奠定了基础。

关键词:

声发射波形数据;模式识别;深度学习;GPU+CUDA;ECAPA-TDNN

声发射(Acoustic Emission, AE)技术是一种基于捕捉材料内部缺陷释放的瞬态弹性波的无损检测方法。通过声发射技术,能够实时监测材料在受到应力作用下的状态变化,从而判断材料的健康状况。传统的声发射技术主要依赖参数数据进行分析,如振幅、能量、上升时间等。然而,声发射波形数据中蕴含着更为丰富的声源信息,这为实现更高精度的模式识别提供了可能性。

随着人工智能(AI)技术的快速发展,特别是深度学习(Deep Learning)的广泛应用,声发射波形数据的模式识别也得到了新的突破。通过结合AI算力资源与深度学习模型,可以充分挖掘波形数据中的信息潜力,实现对复杂声发射事件的高效分类与识别。本文提出了一种基于AI算力资源与深度学习模型的声发射波形数据模式识别方法,旨在提高识别精度和效率,验证其在实际应用中的可行性。

2.1 声发射波形数据的特点

声发射波形数据包含了比传统参数数据更为复杂的时序特征。这些特征不仅反映了声源的基本属性,还包括了材料内部结构的动态变化。通过分析这些波形数据,可以更加准确地识别不同类型的声发射事件,例如铅芯折断、钢球坠落、敲击和摩擦等。

2.2 深度学习模型选型

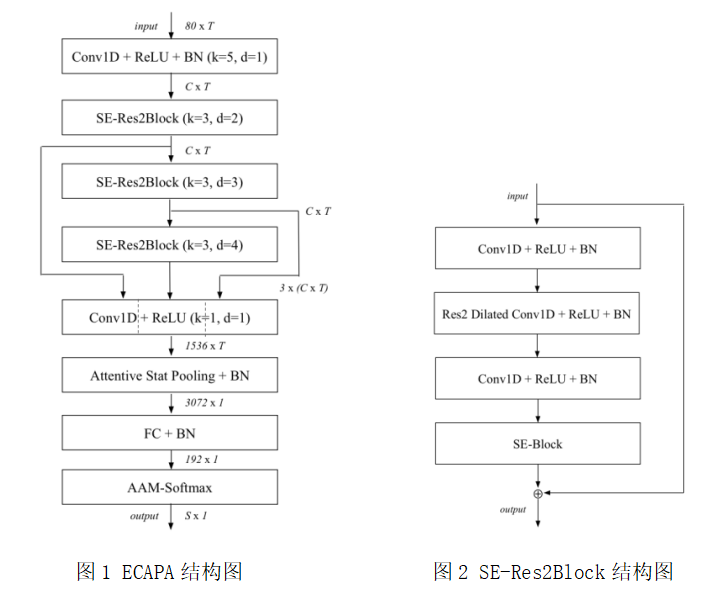

在声发射波形数据的模式识别任务中,选择适当的深度学习模型对于提高分类准确率和模型效率至关重要。本文采用了ECAPA-TDNN模型,该模型最初是为VoxCeleb声纹识别挑战赛而设计的,在处理复杂的声学信号分类任务中表现优异。ECAPA-TDNN通过引入多层特征聚合、多尺度卷积和注意力机制,使其在声发射波形数据的识别中具有显著优势。

2.2.1 波形数据预处理

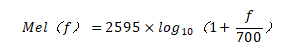

在输入模型之前,声发射波形数据需要经过一系列预处理步骤。首先,采用短时傅里叶变换(Short-Time Fourier Transform,STFT)将一维时域信号转换为二维时频谱图,采用了梅尔频谱(Mel-Spectrogram)作为输入特征,其计算公式为:

其中,f表示频率,梅尔频谱通过将频域信号转换为梅尔标度,降低了高频信号的分辨率,使模型更加关注低频段的变化。具体实现中,参数选择包括:采样率sample_rate} = 16000,FFT长度n_fft = 512,窗口长度win_length = 400 ,帧移hop_length= 160,以及梅尔滤波器个数 n_mels = 80。

2.2.2 主干网络结构

ECAPA-TDNN的主要模型结构如下:

2.2.2.1 引入SE-Res2Block模块

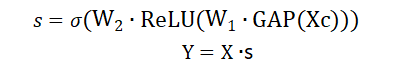

SE-Res2Block模块是ECAPA-TDNN的核心组成部分。该模块结合了Squeeze-and-Excitation (SE)机制和Res2Net的多尺度特征学习能力。SE机制通过自适应调整每个通道的重要性,增强了模型对关键特征的捕捉能力。具体来说,SE模块首先通过全局平均池化(Global Average Pooling, GAP)对每个通道的特征进行全局压缩,生成全局描述向量。然后,该向量通过两个全连接层(Fully Connected, FC)进行非线性变换和缩放,最后通过Sigmoid函数生成每个通道的权重。公式如下:

其中,X为输入特征图,s 为生成的通道权重,Y 为输出特征图。通过这一机制,模型能够强调重要的通道特征,抑制无关或干扰信息。

Res2Net结构通过将卷积层的输入进行分组处理,使得每个分组的特征能够在不同的感受野(Receptive Field)下进行卷积操作,从而学习到多尺度的特征表示。这种多尺度特征学习能力对声发射波形数据中不同频率成分的捕捉尤为重要。

2.2.2.2 将SE-Res2Block模块里的卷积替换成SE-Block模块

在SE-Res2Block模块中,原本的标准卷积操作被替换为SE-Block模块,以进一步增强模型的特征表达能力。SE-Block通过自适应调整每个特征通道的权重,强化了对重要信息的捕捉。具体而言,SE-Block首先通过卷积操作提取初步特征,然后将这些特征输入到SE模块中进行通道注意力计算,最后通过加权的方式生成最终的特征输出。替换后的SE-Block不仅保留了Res2Net的多尺度特征学习能力,还通过SE机制进一步提升了模型对关键特征的选择性。

2.2.2.3 多层特征聚合(Aggregation)

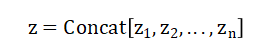

ECAPA-TDNN通过多层特征聚合机制,进一步提升了模型的特征表达能力。多层特征聚合指的是将模型中每一层SE-Res2Block的输出特征都保留并作为后续层的输入特征之一。这种设计的好处在于,不同层次的特征可以在后续卷积层中得到进一步的整合和利用。公式表达如下:

其中, 表示第i层SE-Res2Block的输出特征,Concat表示特征的拼接操作。这种特征聚合方式确保了模型能够综合利用浅层的低级特征和深层的高级特征,提升了模型对复杂声发射信号的识别能力。

表示第i层SE-Res2Block的输出特征,Concat表示特征的拼接操作。这种特征聚合方式确保了模型能够综合利用浅层的低级特征和深层的高级特征,提升了模型对复杂声发射信号的识别能力。

2.2.2.4 多层特征求和(Summation)

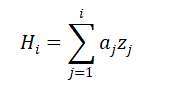

在ECAPA-TDNN中,多层特征求和是指将后续层的SE-Res2Block模块的输入包含前面所有层的输出特征。这种设计使得每一层都能够通过加权的方式获取前面所有层的特征表示,从而在后续卷积操作中更加充分地利用多尺度的特征信息。公式如下:

其中, 表示第i层的输入特征,

表示第i层的输入特征, 为权重参数,

为权重参数, 为前j层的输出特征。通过这种多层特征求和的机制,模型能够更好地综合不同层次的特征,提升特征的表达能力和鲁棒性。

为前j层的输出特征。通过这种多层特征求和的机制,模型能够更好地综合不同层次的特征,提升特征的表达能力和鲁棒性。

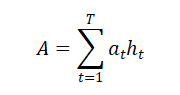

2.2.2.5 引入注意力池化(Attention Pooling)

注意力池化机制在ECAPA-TDNN中被用来进一步增强模型对关键信息的关注度。注意力池化通过对时序特征的权重计算,突出那些对分类任务具有重要贡献的时间片段,从而抑制背景噪声或无关信息的干扰。具体来说,注意力池化首先计算每个时间片段的注意力权重,然后通过加权求和的方式生成最终的特征表示。其计算公式为:

其中, 为第t个时间片段的注意力权重,

为第t个时间片段的注意力权重, 为对应的特征表示,A为加权求和后的全局特征表示。通过这种方式,ECAPA-TDNN能够在时域上更加精确地捕捉声发射信号的变化,提升分类精度。

为对应的特征表示,A为加权求和后的全局特征表示。通过这种方式,ECAPA-TDNN能够在时域上更加精确地捕捉声发射信号的变化,提升分类精度。

这些创新点的综合应用,使得ECAPA-TDNN模型在声发射波形数据的模式识别中表现出色,能够有效地处理复杂、时变的声学信号,实现高精度的分类任务。

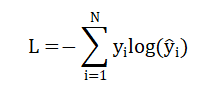

2.2.3 模型训练与优化

模型训练过程中,采用交叉熵损失函数(Cross-Entropy Loss)来衡量预测值与实际标签之间的差异,公式如下:

其中, 为实际标签,

为实际标签, 为模型的预测值。为了加速模型收敛,使用Adam优化器,其更新规则为:

为模型的预测值。为了加速模型收敛,使用Adam优化器,其更新规则为:

其中, 表示参数,

表示参数, 为动量项,

为动量项, 为二阶动量项,

为二阶动量项, 为学习率

为学习率

2.3 GPU+CUDA硬件加速

训练效率。相比传统的CPU计算,GPU在处理大规模矩阵运算时具有天然的优势,尤其是在深度学习模型的训练过程中,能够极大地缩短计算时间,提升模型的训练效果。本文选用的硬件平台包括NVIDIA RTX4090 GPU,配合CUDA 12.4软件环境,为ECAPA-TDNN模型的高效训练提供了强有力的支持。

在具体实现上,利用CUDA对ECAPA-TDNN模型进行了并行化优化,使得模型在训练过程中的矩阵乘法、卷积操作、反向传播等核心计算步骤都能够充分发挥GPU的并行计算优势。通过优化后的模型训练过程不仅在时间上得到了极大的缩短,同时在计算精度上也得到了保障。

3.1 数据集构建与预处理

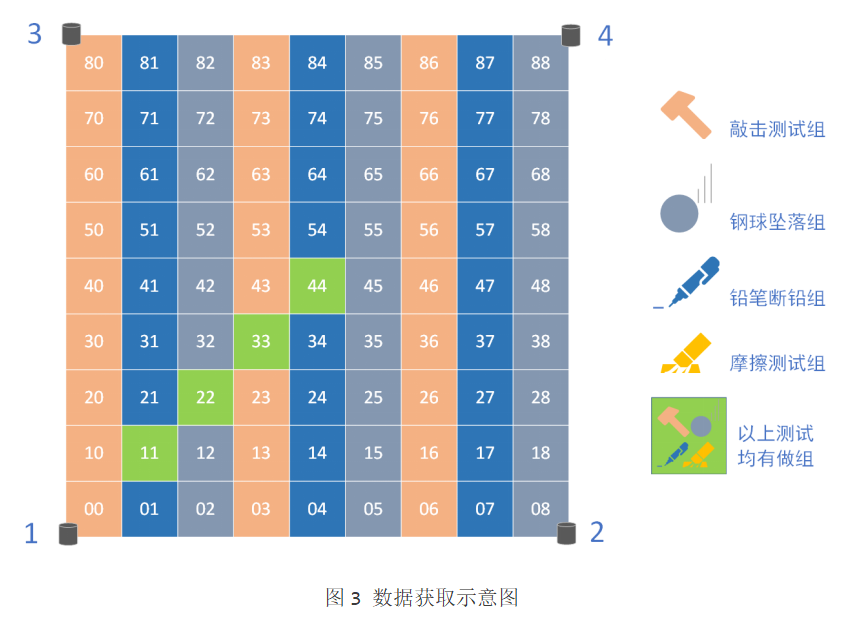

为了评估ECAPA-TDNN模型在声发射波形数据模式识别中的有效性,本实验使用了四种典型声发射事件的数据:断铅、坠落、摩擦和敲击。数据集由多个传感器位置采集,确保了数据的多样性和代表性。具体如下图所示:

3.1.1 数据集划分

训练集:包含从11位置、22位置、33位置和44位置采集的断铅、坠落、摩擦、敲击数据,总计约344,655个样本。

测试集:测试集选用的数据包括4种类型。分别为44位置的摩擦数据,55位置的坠落数据,66位置的敲击数据,77位置的断铅数据。

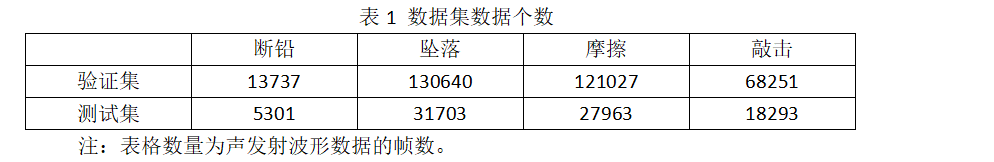

具体样本分布如下:

3.1.2 数据预处理

信号转换:对原始时域信号应用短时傅里叶变换(STFT),并将其转换为梅尔频谱。梅尔频谱的参数设置为:采样率16,000Hz,FFT长度512,梅尔滤波器个数80。此处理确保模型能够更好地捕捉频域特征,尤其是在低频区域。

3.2 模型架构与训练设置

3.2.1 ECAPA-TDNN模型结构

SE-Res2Block模块:每个SE-Res2Block模块通过多层卷积和SE机制增强对通道特征的选择性。模型输入为经过梅尔频谱处理的声发射波形数据,随后通过多层SE-Res2Block进行特征提取。该模块的设计确保了多尺度特征的有效融合,并通过SE机制自适应调整通道权重。

多层特征聚合与求和:各层SE-Res2Block的输出在后续层中进行特征聚合和求和处理。这种设计允许模型综合利用来自不同层次的特征,增强对复杂信号的表示能力。具体特征聚合的公式为:

注意力池化(Attention Pooling):在特征聚合之后,模型使用注意力池化机制,进一步增强对关键时序特征的捕捉。注意力池化计算每个时间片段的权重,并对特征进行加权求和,从而生成最终的全局特征表示。

3.2.2 训练设置

优化器与损失函数:使用Adam优化器,初始学习率设置为10-3,每10轮训练后衰减一半。损失函数采用交叉熵损失,计算模型预测与实际标签之间的差异。训练过程中,定期监控损失值和准确率,以确保模型的稳定收敛。

训练过程:训练在NVIDIA RTX4090 GPU上进行,CUDA版本为12.4。总训练轮数设置为2000轮,每轮记录损失值变化和准确率。此外,在CPU环境下也进行了5轮训练对比,以展示GPU加速对训练效率的提升。

3.3 测试流程与评价指标

3.3.1 测试流程

在测试阶段,输入独立于训练集的数据,验证模型的泛化能力。测试数据经过与训练数据相同的预处理步骤,以确保一致性。

通过混淆矩阵分析各类事件的识别准确率,并使用标准评价指标如准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1值进行评估。

3.3.2 评价指标

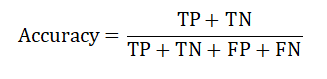

准确率(Accuracy):模型对测试数据整体分类的准确性,定义为:

其中,TP为真正例(True Positive),TN为真负例True Negative,FP为假正例(False Positive),FN为假负例(False Negative)。

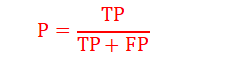

精确率(Precision):特定类别中,正确分类为正例的样本比例。

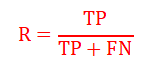

召回率(Recall):特定类别中,实际为正例的样本中被正确分类的比例。

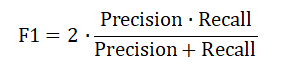

F1值:精确率和召回率的调和平均数,公式为:

4.1 训练过程中的表现分析

4.1.1 GPU与CPU训练对比:

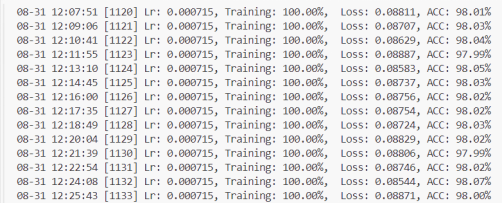

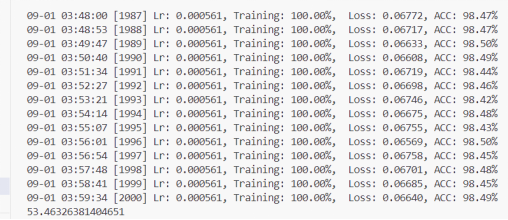

训练时间:GPU训练的效率明显优于CPU。在2000轮训练中,GPU用时36小时,如下图4,图5所示;而CPU仅进行5轮训练便耗时8天,如下图6所示。

图4 GPU训练开始

图5 GPU训练2000轮用时

图6 CPU训练5轮用时

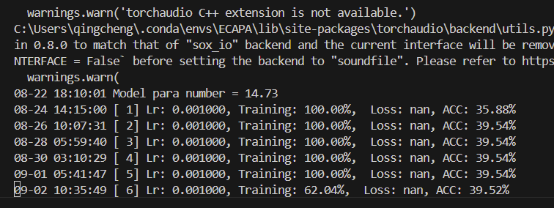

收敛性:GPU训练的损失值迅速下降,并在500轮左右达到稳定,准确率逐渐提高;而CPU由于计算能力限制,训练过程中收敛缓慢且不稳定,损失值波动较大。图7展示了GPU与CPU训练的损失值变化曲线。

从图中可以看出,随着训练时间的增加,损失函数值不断减小,识别准确率不断增加。说明在训练的过程中,模型越来越收敛。

4.1.2 模型收敛与精度

在GPU训练下,ECAPA-TDNN模型在第500轮时损失值趋于稳定,测试集上的准确率达到93.7%,表现出良好的收敛性。相比之下,CPU训练5轮后尚未达到理想的收敛状态。

4.2 测试结果与模型性能分析

4.2.1 总体准确率

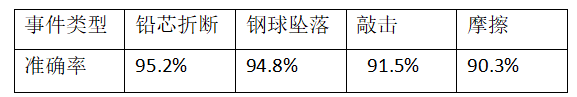

测试结果显示,ECAPA-TDNN模型在测试集上的整体识别准确率达到93.7%。其中,断铅和坠落事件的识别表现最好,准确率分别为95.2%和94.8%;摩擦和敲击事件的识别准确率略低,但均超过90%。

测试结果显示,ECAPA-TDNN模型在测试集上的整体识别准确率达到93.7%。其中,断铅和坠落事件的识别表现最好,准确率分别为95.2%和94.8%;摩擦和敲击事件的识别准确率略低,但均超过90%。

表1展示了各类声发射事件的识别准确率:

表1. 各类声发射事件识别准确率

断铅事件:识别准确率最高,主要得益于其独特的高频成分。混淆矩阵显示,断铅事件几乎未出现误分类。

摩擦事件:由于与其他事件在频域上存在部分重叠,摩擦事件有部分样本被误分类为敲击事件,导致准确率相对较低。

坠落事件:低频特征明显,识别稳定。准确率达94.8%。

敲击事件:信号时变性强,但ECAPA-TDNN模型仍能较好地捕捉其特征,准确率在90%以上。

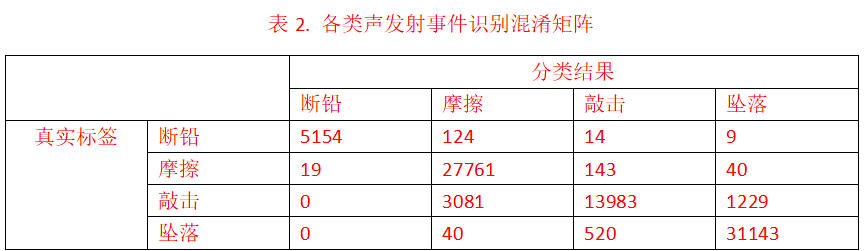

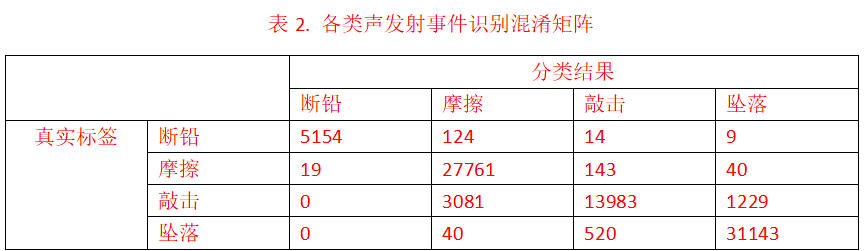

4.2.2 各类事件的识别性能

上表为测试集的混淆矩阵数据。

断铅事件:有少量断铅数据被识别成了其他类别,只有极少数其他类别被识别成断铅数据。可能原因是断铅数据有独特的高频成分。

敲击事件:信号时变性强。有3081个样本被识别成了摩擦信号,有1229个样本被识别成了坠落信号。

4.2.3 各类事件的识别性能

敲击事件的召回率及F1值较低,敲击的部分数据被识别成了其他数据,说明模型对敲击信号的特征提取能力还需提高。

4.3 模型优化与改进方向

虽然实验结果显示了较高的识别准确率,但在部分声发射事件上仍然存在一定的误差,尤其是在敲击事件的识别中。可能的原因包括:

数据不平衡: 不同事件类型的数据量存在不平衡,这可能导致模型对少数类事件的识别准确率下降。未来可以通过数据增强技术或增加数据采集量来改善这一问题。

针对声发射数据高频信号的特性,未来可优化ECAPA-TDNN模型预处理步骤,考虑去除梅尔频谱以直接保留高频信息,可能提升模型对高频声发射事件的识别精度。同时,需验证此改动对模型整体性能的影响,确保优化方向的科学性与有效性。

本文通过结合AI算力资源与深度学习模型,成功实现了对声发射波形数据的高效模式识别。实验结果表明,GPU加速环境下的ECAPA-TDNN模型能够在较短时间内实现高准确率的模式识别,相较于传统的参数数据分析方法具有显著优势。

未来工作中,可以进一步优化深度学习模型的结构,提升其在不同声发射事件中的泛化能力。此外,探索更高效的数据处理技术,尤其是针对复杂环境下的噪声处理,将有助于提升模型的鲁棒性。研究结果为无损检测技术的发展提供了新的思路和工具,未来在工程应用中具有广阔的前景。

1. Hu, J., Shen, L., & Sun, G. (2018). Squeeze-and-Excitation Networks. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (pp. 7132-7141).

2. Gao, S., Cheng, M., Zhao, K., Zhang, X., Yang, M.-H., & Torr, P. H. S. (2019). Res2Net: A New Multi-Scale Backbone Architecture. IEEE Transactions on Pattern Analysis and Machine Intelligence.

3. Desplanques, B., Thienpondt, J., & Demuynck, K. (2020). ECAPA-TDNN: Emphasized Channel Attention, Propagation and Aggregation in TDNN Based Speaker Verification. In Proceedings of Interspeech 2020 (pp. 3830-3834).

4. Nagrani, A., Chung, J. S., & Zisserman, A. (2020). VoxCeleb: Large-Scale Speaker Verification in the Wild. Computer Speech & Language, 60, 101027.

5. Snyder, D., Garcia-Romero, D., Sell, G., Povey, D., & Khudanpur, S. (2018). X-Vectors: Robust DNN Embeddings for Speaker Recognition. In Proceedings of IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) (pp. 5329-5333).

6. Kingma, D. P., & Ba, J. (2015). Adam: A Method for Stochastic Optimization. In Proceedings of the 3rd International Conference on Learning Representations (ICLR).

7. Davis, S. B., & Mermelstein, P. (1980). Comparison of Parametric Representations for Monosyllabic Word Recognition in Continuously Spoken Sentences. IEEE Transactions on Acoustics, Speech, and Signal Processing, 28(4), 357-366.